使用LM Studio快速在本地体验最新的开源大模型

最近各公司团队密集发布自己新的大语言模型,Google发布了Gemini,微软发布了Phi-2小模型,Mistral发布了第一个MOE模型Mixtral-8x7B,都在宣传"最顶","天花板","最快",到底哪个模型更适合自己的项目,就需要亲自去部署和使用了.基于这个需求有了很多方便本地部署的第三方工具,比如oolama,vllm,Text Generation Inference等等,但是这些工具都有一定的技术门槛,LM Studio通过简单的操作就能下载各模型,通过GUI软件界面配置模型,一键就能启用和OpenAI兼容的API,可以配置使用CPU和内存做模型推理,减少传统大模型对GPU的依赖.软件暂时还不支持并发推理,所以个人研究使用没问题,不适合生产环境.

1. 下载软件

到官网下载软件:https://lmstudio.ai,提供Linux、Mac、Windows版本下载。软件更新比较快,部分模型需要Beta版本才能使用,Phi-2只能运行在0.2.8 Beta版,请按需选择。

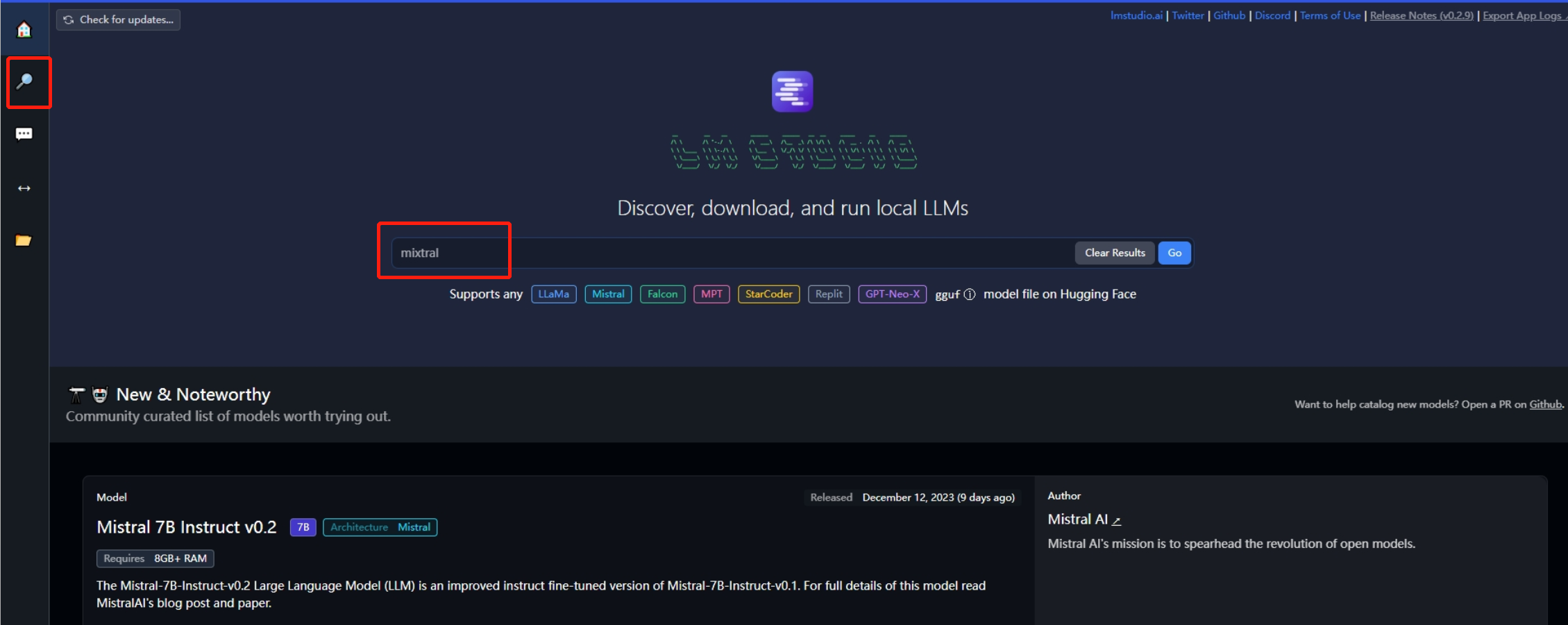

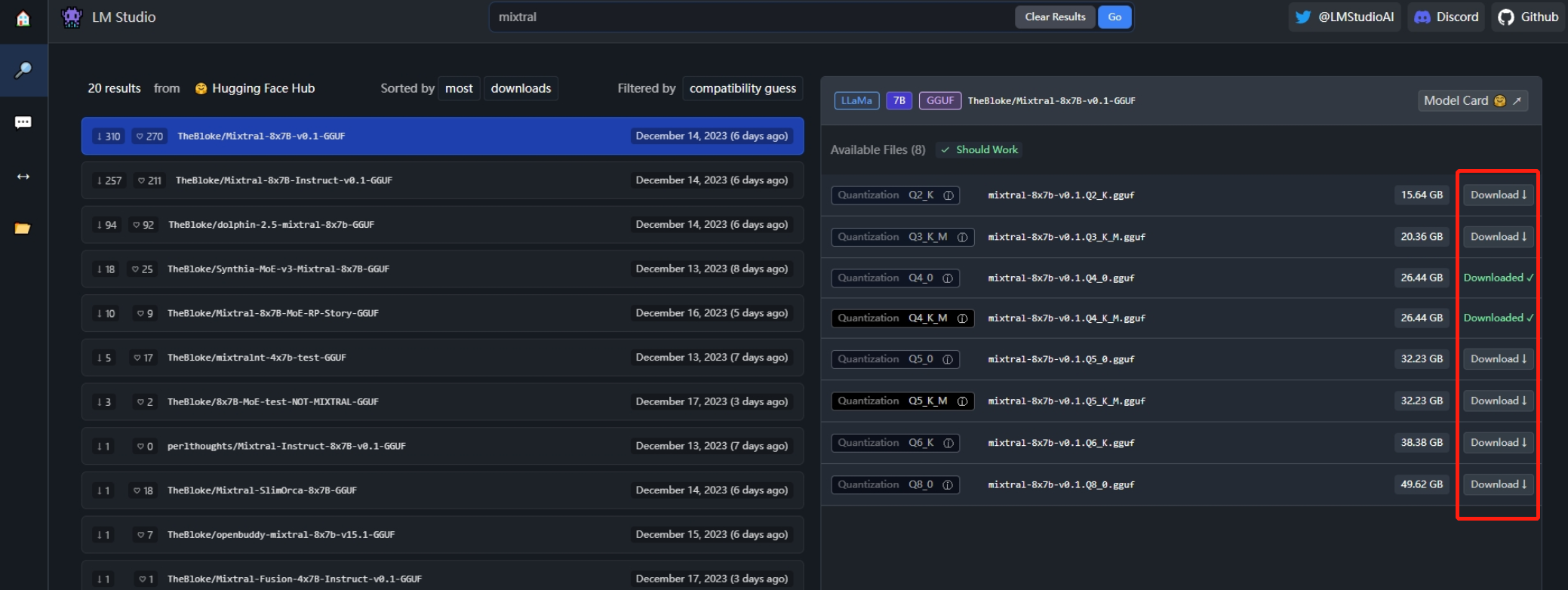

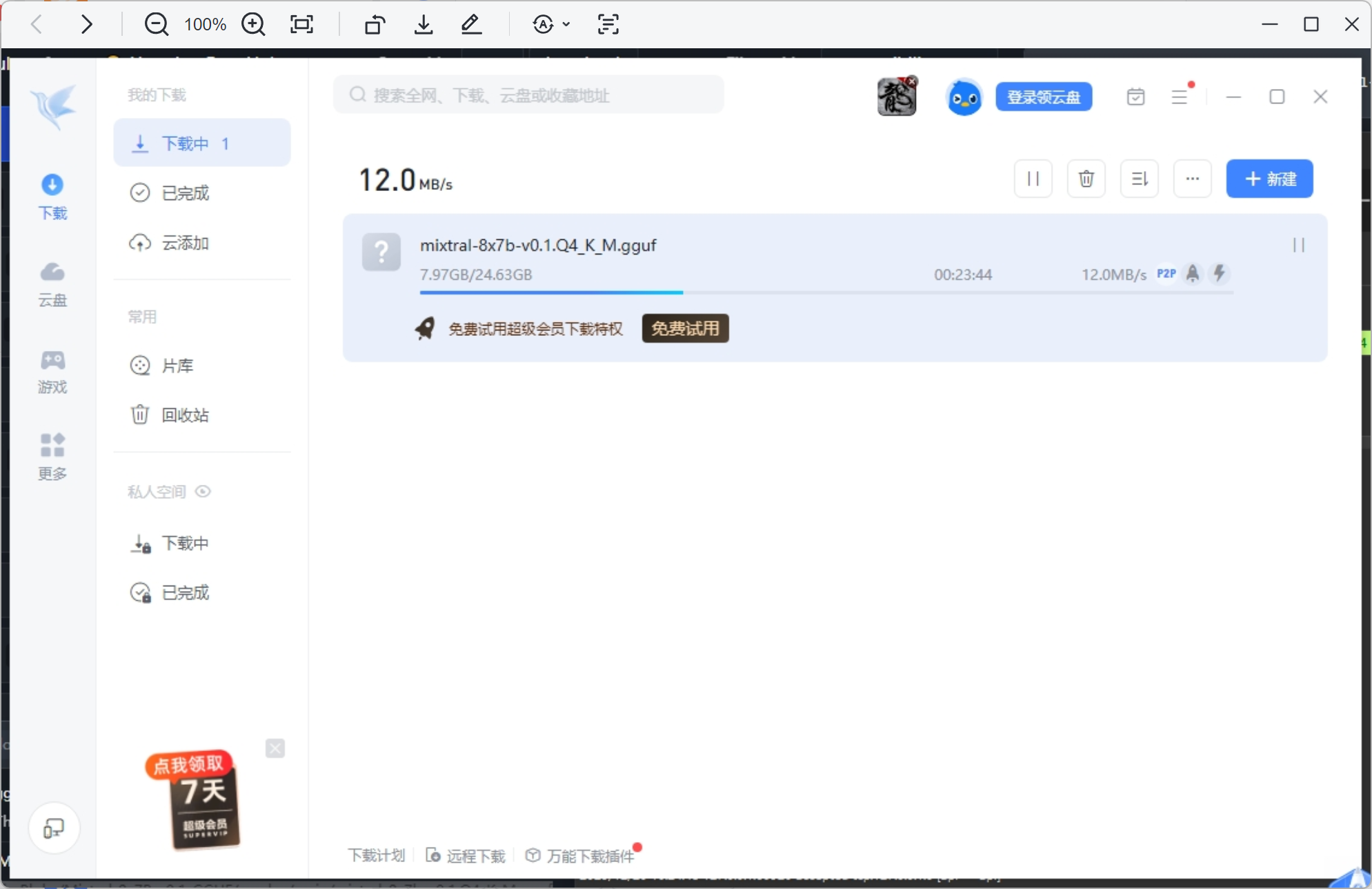

2. 下载模型

搜索模型关键词,就会列出模型,选中"compatibility guess"按钮。LM Studio会展示它认为可以在计算机上运行的那些模型。点击左边的一个模型,右边就会显示可用的版本,并显示那些根据你的电脑规格应该可以工作的模型。根据计算机的能力/速度,较大的模型将更准确,但速度较慢。模型是从huggingface下载,所以要先处理网络问题才能下载,在这里有个小技巧,点击下载后,把下载地址放到迅雷中下载,这样就能绕过网络问题满速下载了。

3. 模型配置

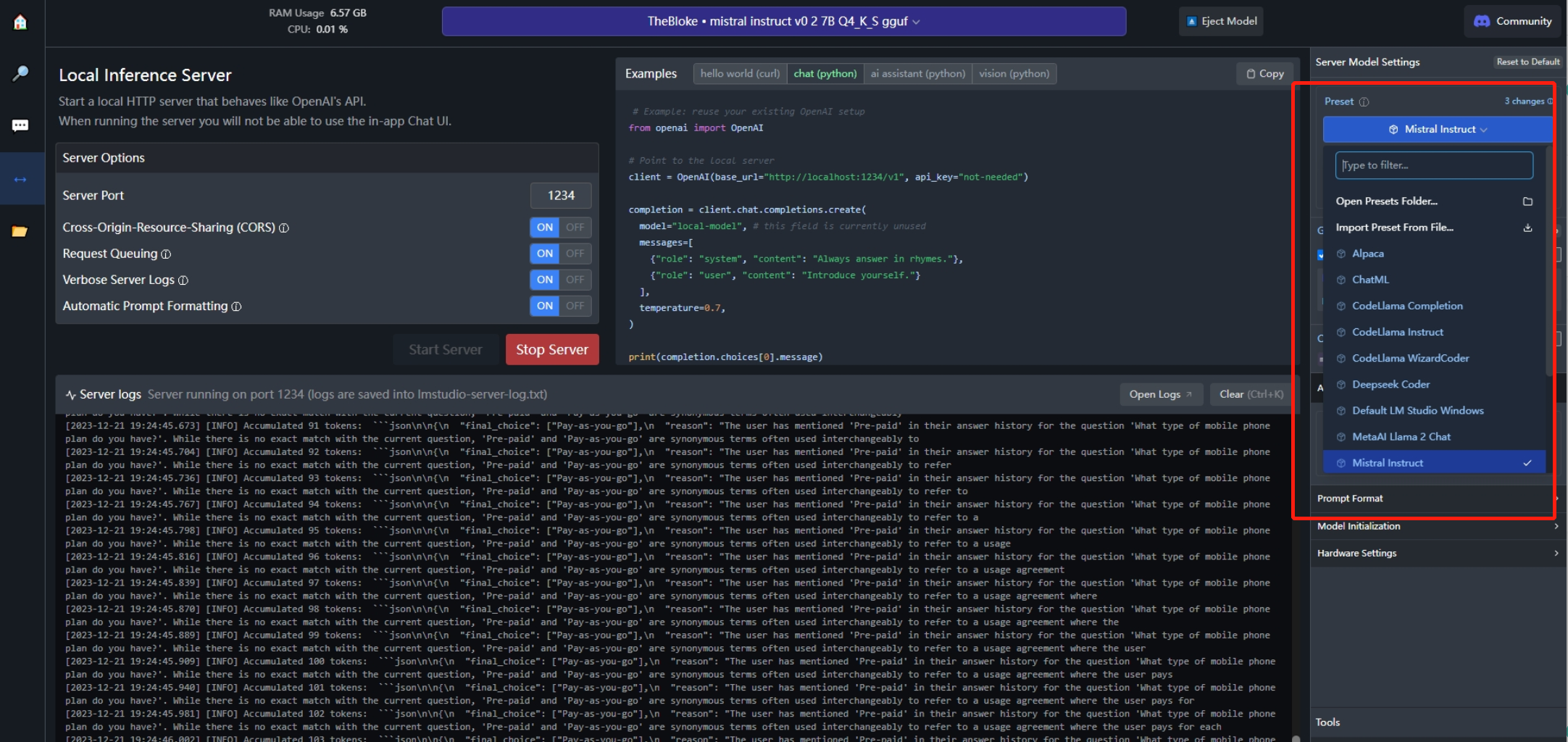

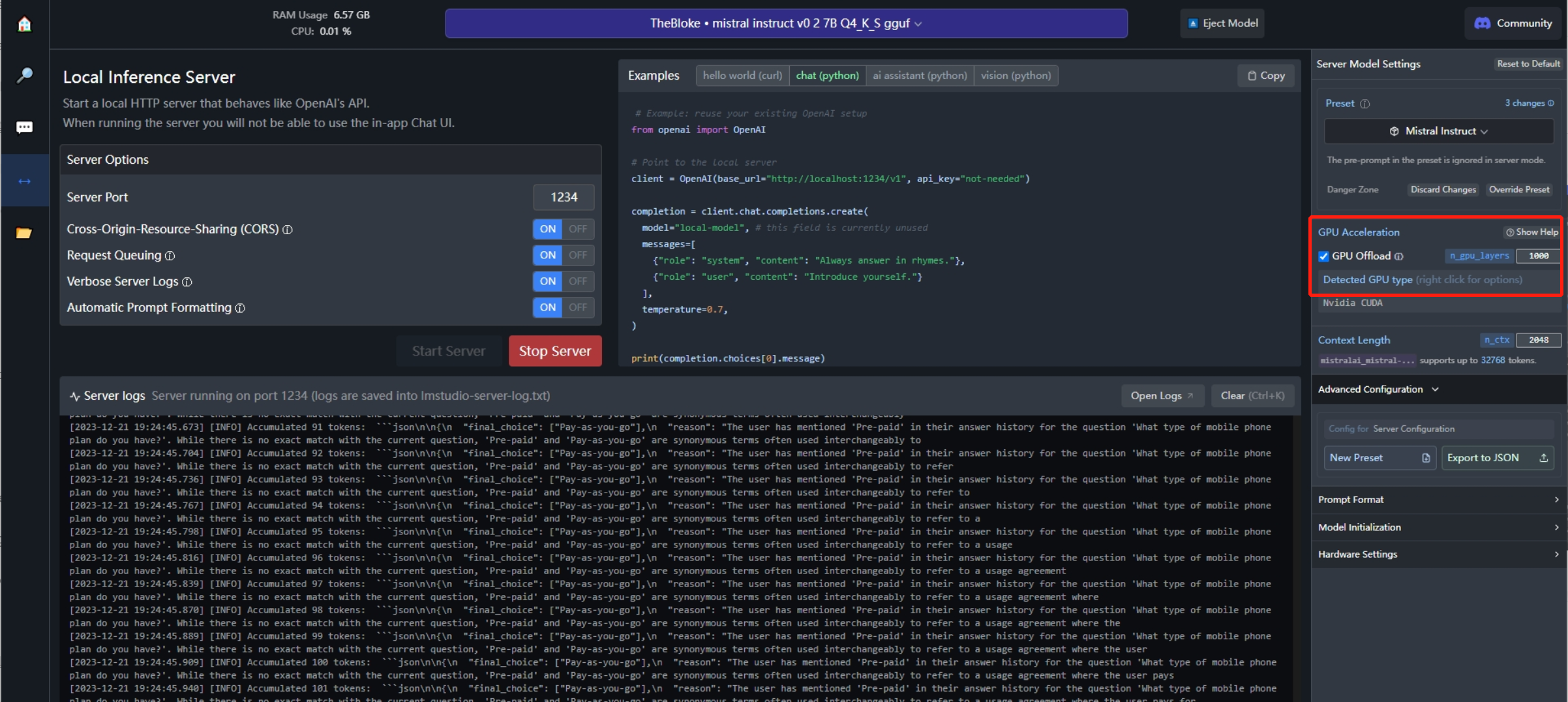

模型配置只用注意两个地方就行。

- 选择专用配置文件,如果没有专用配置,就使用默认的配置。

- 软件默认设置是使用CPU和内存完成推理,如果你有GPU,就可以将工作交给显卡,虽然提示模型只有32层,可以设置超过100,就能减少CPU的占用,提高推理速度。

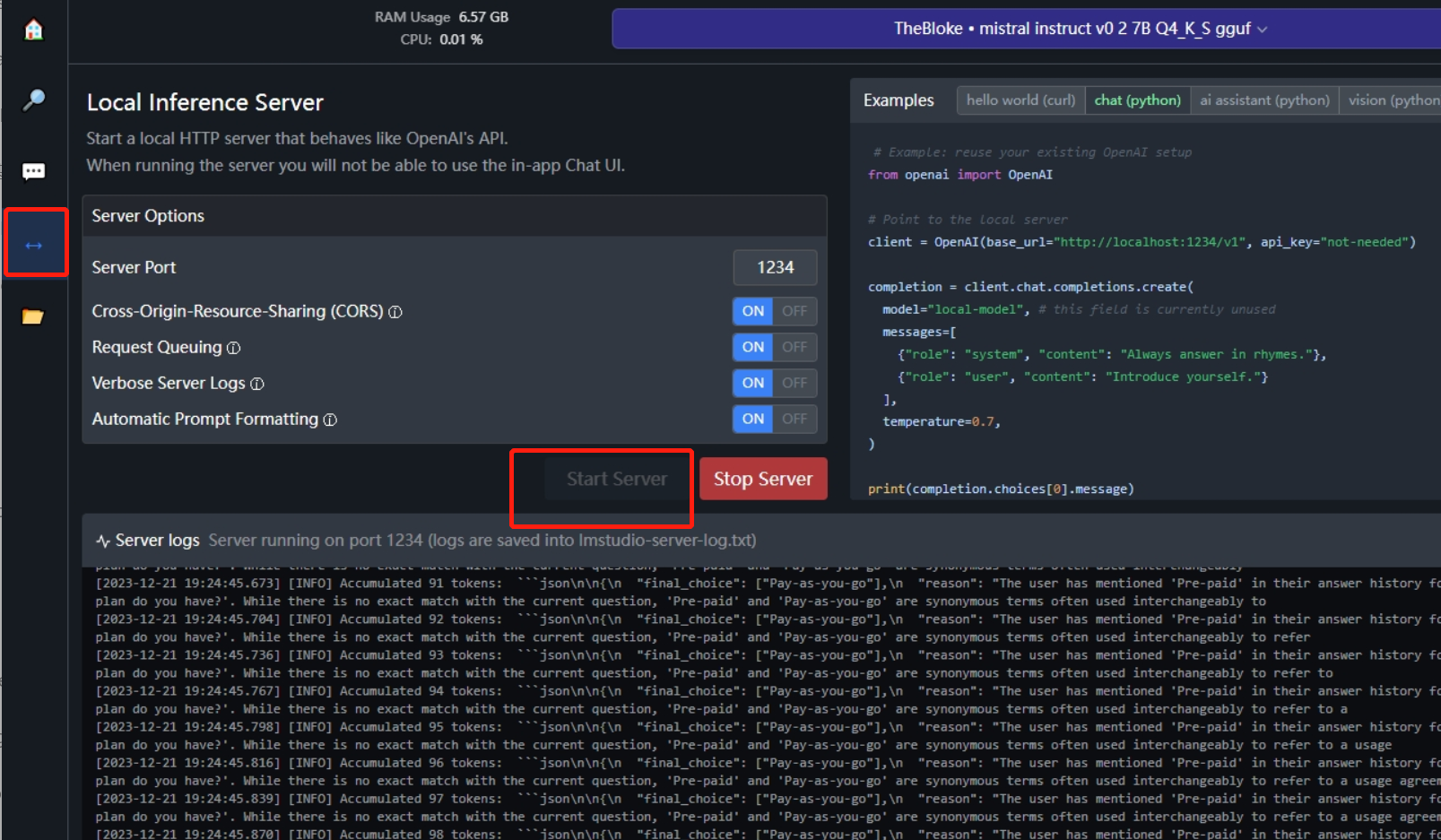

4. 启用HTTP API

如截图所示,启用Http API只用点击启动按钮就行,就可以本机调用或局域网调用了,局域网注意打开防火墙。下面会显示调用Log纪录。另外调用API要设置Max_Token参数!(在这踩过坑)。

5.小结

以上就是LM Studio的介绍了,软件非常方便,但是暂时还不支持并发推理,所以个人研究使用没问题,肯定不适合生产环境,如果生产环境有需求可以选择Text Generation Inference或者vllm。